O studentă a folosit inteligența artificială pentru a traduce limbajul semnelor în limba engleză în timp real

O studentă a utilizat algoritmi AI pentru a reuși să transforme limbajul semnelor în cuvinte în engleză.

Pentru mulți oameni, apelurile online au devenit o parte importantă a rutinei de lucru de zi cu zi. Companiile de software au ținut și ele pasul, adăugând mai multe funcții utile acestor platforme, cum ar fi evidențierea persoanei care vorbește.

Însă, atunci când o persoană folosește limbajul semnelor, software-ul nu îi oferă nicio recunoaștere specială. Mai mult, aceste platforme pot acționa ca o barieră împotriva celor care se bazează pe limbajul semnelor.

Pentru a reduce acest decalaj, Priyanjali Gupta, o studentă la inginerie de la Vellore Institute of Technology (VIT) din Tamil Nadu, a creat un model de inteligență artificială care traduce limbajul american al semnelor în limba engleză, în timp real. Ea și-a împărtășit creația pe LinkedIn, ajungând la peste 60.000 de aprecieri pe platformă.

Gupta a declarat că factorul determinant al software-ului a fost mama ei, care o încuraja să facă ceva diferit în calitate de studentă la inginerie. „M-a făcut să mă gândesc la ce aș putea face folosind cunoștințele și aptitudinile mele. Ideea de tehnologie incluzivă m-a frapat", a declarat Gupta într-un interviu acordat Interesting Engineering.

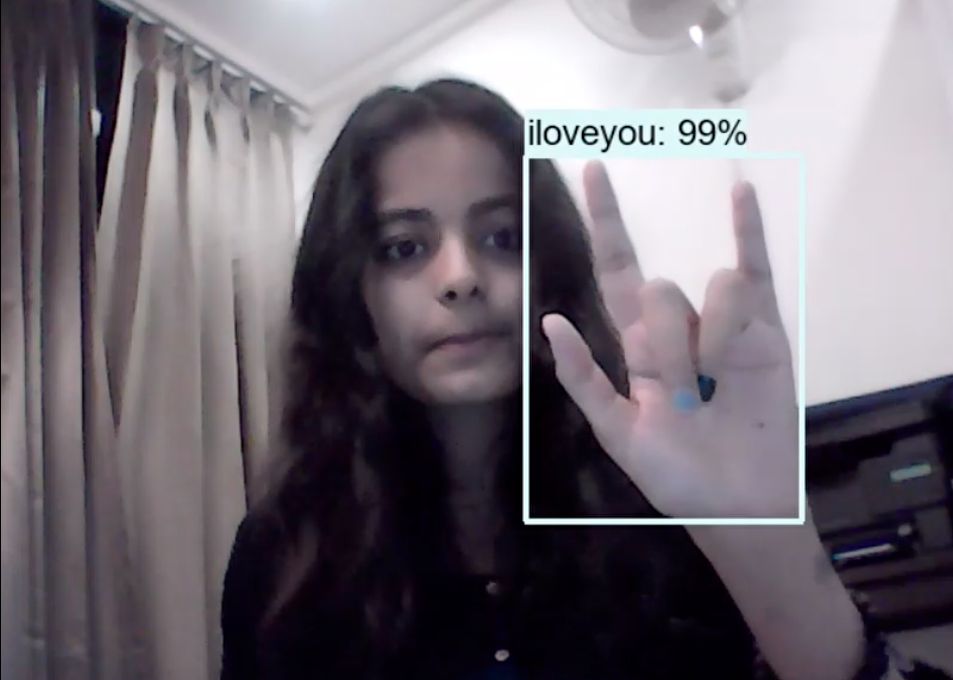

Sistemul dezvoltat de Gupta convertește semnalele în text în limba engleză prin analizarea mișcărilor mai multor părți ale corpului, cum ar fi brațele și degetele, folosind tehnologia de recunoaștere a imaginilor. Ea a digitalizat limbajul semnelor folosind mostre captate de la câteva persoane pentru a dezvolta tehnologia, după cum explică în postarea sa de pe Github - care a devenit virală.

Software-ul de inteligență artificială oferă o modalitate dinamică de comunicare cu persoanele surde sau cu deficiențe de auz, deoarece rezultatele se văd în timp real. Cu toate acestea, este doar în stadiul inițial. Acesta poate converti mișcările în aproximativ șase gesturi - Da, Nu, Te rog, Mulțumesc, Te iubesc și Bună ziua. Pentru a crea un model mai fiabil, ar fi nevoie de multe date despre limbajul semnelor, dar, la stadiul de concept, acesta pare să funcționeze cu adevărat.

Gupta a spus că setul de date a fost realizat manual cu o cameră web și a primit ulterior adnotări. Modelul este antrenat doar pe cadre unice, așa că nu poate detecta încă videoclipuri sau succesiuni de semne. Gupta a spus că în prezent cercetează utilizarea rețelelor LSTM (Long-Short Term Memory Networks), o rețea neuronală artificială recurentă, pentru a încorpora mai multe cadre în software-ul ei.

__________________________________________________________________________________________________

Urmăriți emisiunile preferate pe protvplus.ro: